前言

在2025年时,人工智能已深入到生活的各个地方,从医疗诊断到金融决策,算法的影响力到处都有。可是,其背后的“黑箱”特性却引起了公众对于公平性、隐私以及伦理的争议。算法透明度这不仅是技术方面的问题,还和社会信任以及责任相关。本文会对这一议题的核心矛盾展开探讨,也会探讨其面临的现实挑战,还会探讨可能的解决路径。

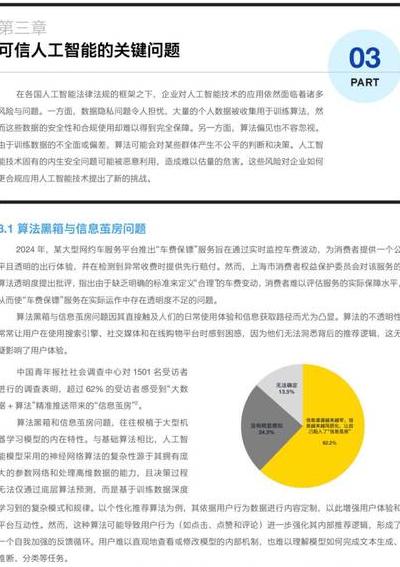

算法黑箱的伦理困境

想象一下,你被银行拒绝贷款,然而却没办法知道AI模型是依据哪些数据做出的决定。这种“黑箱”现象在深度学习领域特别常见。复杂的神经网络借助海量数据自我优化,可是连开发者都难以解释其决策逻辑。这种不透明性可能致使歧视性结果出现,例如某些族裔或性别群体被系统性地排除在机会之外。

更麻烦的是,AI用于司法量刑或者招聘时,缺乏透明度会直接侵犯公民权利。2023年欧盟出台了《人工智能法案》,该法案要求高风险AI系统必须具备“可解释性”。然而,技术实现起来仍然困难重重。开发者不得不在模型性能和可解释性之间进行权衡,并且目前还没有完美的解决办法。

隐私保护与透明需求的冲突

透明度常常被看作是解决AI信任问题的有效办法,然而过度披露却有可能对用户隐私造成威胁。比如说,要是医疗AI公开训练数据的详细情况,那么患者的敏感病史就有可能被反向推导出来。谷歌健康曾经因为公开肺癌预测模型的参数而遭遇诉讼,最后不得不删除部分数据。

差分隐私等技术尝试在数据匿名化与模型解释之间达成平衡,不过它的计算成本很高。2024年Meta提出了“联邦解释”框架,该框架能让用户查询AI决策,同时不会暴露原始数据,这个折中的方案正在金融领域进行试点,其效果还有待验证。

监管政策的全球博弈

各国对于算法透明的态度,差别非常明显。中国的《生成式AI服务管理办法》着重强调“可控可溯”,它要求企业对核心算法进行备案。而美国则更多依靠行业自律,像IBM的“AI事实标签”计划就是如此。这种分化使得跨国企业必须要为不同市场开发多套系统,进而导致合规成本急剧增加。

国际组织正致力于寻求协调 ,经济合作与发展组织在2025年初发布的《算法透明度分级指南》提出了三级披露标准 ,分别是基础级也就是功能描述 、进阶级即决策逻辑 、专家级为完整代码 ,然而发展中国家担心这会成为技术垄断的新壁垒 。

技术创新的破局尝试

科学家们正在从多个方向突破透明度瓶颈 ,MIT开发的“概念白盒”模型用人类可理解的符号替代神经网络参数 ,该模型在保持90%准确率的同时实现了决策可视化 ,另一项突破来自剑桥团队 ,他们利用“对抗性探测”技术反向重构了AI的推理链条 。

开源社区同样起着关键作用, Face的“模型卡片”标准,要求开发者标注训练数据偏差以及潜在风险,目前已有超过2000家企业采用了该标准,然而这种自发形成的规范,能不能抵御商业机密带来的压力,仍然无法确定。

企业与公众的认知鸿沟

多数用户对透明度的理解只是停留在“看到代码”这个层面,然而实际需求要复杂得多。推特在2024年进行了用户调研,结果显示,68%的受访者想知道“为什么给自己推送这条广告”,而不是关注技术细节。这就需要企业用非技术的语言来传达AI逻辑,就像亚马逊的“影响分数”那样,能直观地展示推荐因素的权重。

教育的缺失,使得沟通的难度加大了。只有12%的成年人,能够正确区分“算法偏差”与“数据偏差”。非营利组织AI Now提出倡议,要把算法素养纳入基础教育,该组织所开发的互动教程,已经在瑞典200所学校进行试点。

未来路径:透明与效能的再平衡

完全透明的人工智能可能永远只是一种理想状态。自动驾驶系统需要实时处理万亿级别的数据,若要解释每个转向指令,就会拖慢响应速度。军工领域的人工智能因为安全方面的考虑,必须进行部分保密。我们或许需要接受“有限透明”这样的现实情况,可通过第三方审计以及事后追溯机制来进行弥补。

区块链技术给出了新的思考方向,IBM把AI训练数据的哈希值上传到链上,这样做既能保护商业秘密,又能让监管方验证数据是否合规,这种“可验证不透明”的模式或许在2026年之前会成为行业的标准配置。

当算法对人类命运的介入程度越来越深,我们是否打算用透明度来换取便利?欢迎分享你受到AI决策影响的经历,或者谈谈你对“可解释性”与“实用性”优先级的看法。点击❤️能让更多人加入讨论。