在AI以及深度学习的领域中,数据就好比烹饪用的食材,而数据清洗是一道关键工序,其作用是剔除腐叶、打磨原石。到了2025年,即便模型架构不断更新变化,然而90%的AI项目成败依旧由数据质量决定。本文会揭示数据清洗的核心方法论,还会结合实战案例,帮你避开“垃圾进垃圾出”的陷阱。

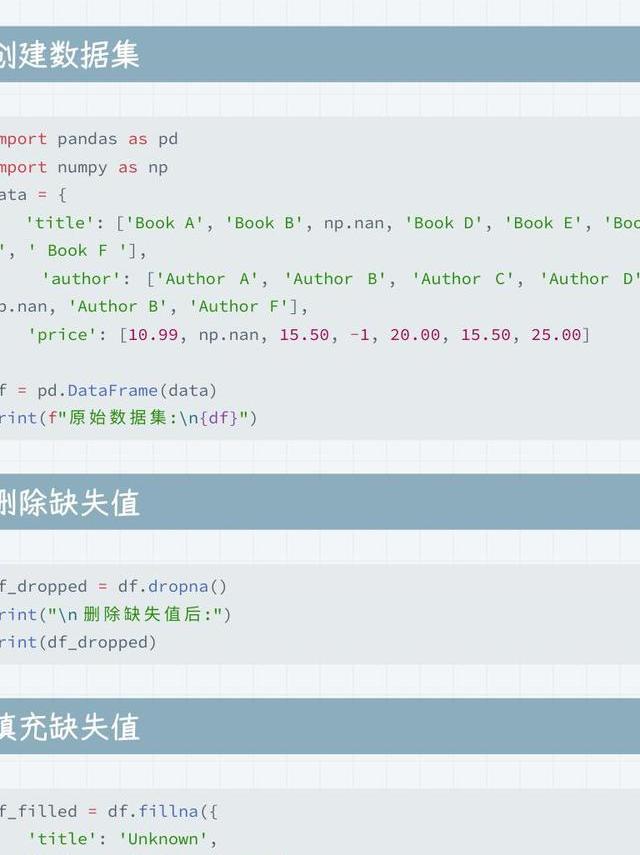

缺失值处理的智慧抉择

当数据里出现缺失值的时候,粗暴进行删除操作,可能会损失30%的有效信息。拿医疗数据集来说,如果直接删除含有缺失值的患者记录,就会致使模型忽略罕见病例的特征。更明智的做法是采用多重插补法

实际项目中,的()函数能实现线性插值,而-learn的它适合分类数据。曾经有一个电商推荐系统的案例,这个案例运用KNN算法来补全用户年龄字段,最终使得点击率预测的准确率提高了17%。要记住,缺失值本身也有可能是重要特征。

异常值的侦探与审判

在信用卡欺诈检测里,存在一些交易记录,这些交易记录偏离群体达到3个标准差,而这些记录往往隐藏着真正的金矿。传统的Z-score方法适用于正态分布的数据,不过对于偏态分布的数据,则应该采用MAD(中位数绝对偏差)PyOD库提供了20多种离群检测算法,在这些算法里,LOF算法能够有效地识别出局部密度异常点。

某共享单车项目曾误删了凌晨3点的骑行记录,之后才发现这些记录反映的是夜班族的真实需求。箱线图可视化异常值,再结合业务逻辑判断。对于时间序列数据,滑动窗口标准差法

文本数据的深度净化

在GPT进行训练数据清洗时,特殊符号的处理会对生成质量产生直接影响。正则表达式就像这样 。r”[^a-zA-Z0-9s]”可过滤乱码,但要注意保留é等合法字符。更高级的BPE(字节对编码)

处理中文文本时,Jieba分词某舆情分析项目通过构建自定义词典,关键词提取准确率从68%提升到了89%。停用词表要依据业务进行定制,在金融领域要保留“涨停”等专业术语。记住这一点。

特征工程的降维艺术

当数据集包含500+维特征时,PCA(主成分分析)UMAP降维SHAP值分析能够压缩维度,还可以解释特征重要性。竞赛冠军方案表明,在信用卡违约预测里,组合使用PCA和t-SNE,效果是最佳的。

实际应用时需要注意,温度数据若摄氏和华氏混用,就会致使模型崩溃。建议先使用的观察特征间关系,对高度相关特征(相关系数>0.9)采用方差膨胀因子(VIF)10的特征剔除掉,结果使得RMSE降低了23%。

自动化清洗的边界把控

尽管等自动化清洗工具能够节省百分之八十的时间,不过完全依赖人工智能是存在风险的。某家自动驾驶公司曾经因为自动过滤雾天数据,致使系统在恶劣天气时失灵。建议建立人工复核机制

在搭建自动化流水线时,Great 库可以定义数据质量规则,比如规定年龄字段不能为负数。不过要留意设置弹性阈值,新冠疫情期间体温数据的正常范围需要动态调整。要记住,任何自动化规则都应该保留接口。

数据血缘的追踪溯源

在神经网络训练中,某个被误标的图像可能污染整个测试集。数据版本控制DVC能够如同使用Git管理代码那般追踪数据的变更情况。某医疗AI团队借助回溯数据的血缘关系,发现标注员把良性肿瘤错误地标为了恶性,进而及时防止了模型出现误诊的情况。

建议为每个数据样本添加元数据标签记录采集的时间,记录设备的型号等。当模型出现偏差的时候,可以快速定位出问题批次。比如说发现夜间拍摄的X光片识别率低,这可能是照明条件所产生的影响。建立起完整的数据溯源链,能够让清洗过程变得透明且可信。

在数据清洗时,你有没有碰到自动化工具解决不了的“脏数据”难题?欢迎讲讲你的实战经历,点个赞让更多同行看到这些避免踩坑的方法。