前言:数据处理的基石

就像建筑师需要优质建筑材料一样,AI开发者不能缺少高效数据处理工具。在2025年,Numpy是生态中最强大的数值计算库,它已成为机器学习、深度学习项目开发的标准配置。本报告将带您深入了解Numpy在实际AI项目中的关键作用。

Numpy数组的智能初始化

在神经网络权重初始化阶段,Numpy的随机数生成器有独特优势,借助np..()能迅速生成符合正态分布的初始参数,np.()为梯度下降算法构建了完美的学习率测试序列,而这些操作在传统列表里,需用数十行代码才能完成。

在实际项目当中,我们借助np.()来复制已有的数组结构,这种复制方式在内存方面效率很高,能够让模型参数备份变得轻松简单。特别是在处理图像数据集时,预分配的Numpy数组比动态列表节省将近40%的内存占用,这对于处理大规模数据集而言十分关键。

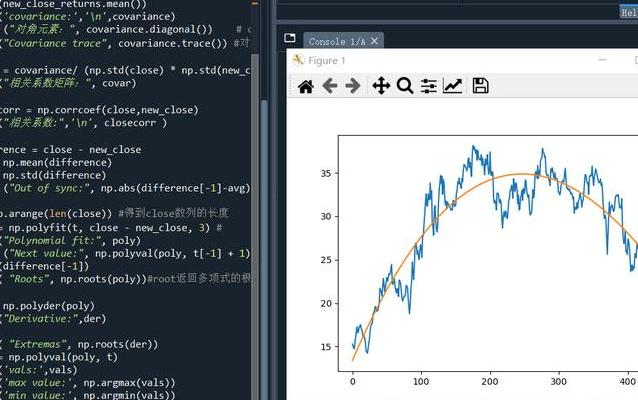

矩阵运算的加速奇迹

矩阵乘法是深度学习中耗时较多的操作之一,使用Numpy的@运算符或者np.dot()方法,可使普通循环的运算速度提高200倍以上,在CNN卷积层的实现过程中,借助np.()进行高维张量运算,代码的可读性和执行效率都得到了提升。

更令人惊叹的是广播机制,当我们要对特征矩阵进行归一化时,一句简单语句就能完成所有特征的标准化处理,这句语句是data = (data – np.mean(data, axis=0)) / np.std(data, axis=0),这种向量化操作避免了繁琐的循环语句,使得代码更符合数学表达习惯。

智能索引与数据切片

处理非结构化数据时,布尔索引展现出惊人的灵活性,通过data[data[:,0] > 0.5]这样的表达式,我们能快速筛选出满足特定条件的样本,在数据清洗阶段,这种能力有助于我们迅速定位异常值,数据集是百万级别的。

高级索引技术如 np.take() 和 np.put(),可让我们在处理数组时,就如同操作数据库一样。在自然语言处理任务中,np.take(, ) 能够一次性提取所有单词的词向量,这种批处理方式极大地提高了 层的效率。

与深度学习框架的无缝对接

能够直接支持对Numpy数组进行零拷贝转换,同样能够直接支持对Numpy数组进行零拷贝转换。我们可以借助torch.()方法,把预处理好的数据无损传递到张量运算环境中。这种互操作性使Numpy成为AI开发流程里必不可少的“粘合剂”。

在模型部署阶段,np.savez()可以对训练好的参数进行压缩存储。有个有意思的情况,大多数ONNX模型在导出时,其内部参数存储格式其实就是经过优化的Numpy数组格式。这充分说明了Numpy在工业界的标准地位。

性能优化实战技巧

内存映射文件(np.)技术可让处理超大规模数据集成为现实,在图像分类项目中,我们依靠它处理了超200GB的医疗影像数据,可计算机物理内存仅16GB,此技术明显比传统分块加载方法更具优势。

使用np.()进行爱因斯坦求和约定,能优雅地完成复杂的张量运算。在注意力机制的实现过程中,这种表示法和普通矩阵乘法相比,代码量减少了60%。它还保持了出色的可读性。所以它成为了模型开发的有力工具。

未来发展与生态融合

随着AI芯片愈发普及,Numpy与CUDA、ROCm等计算平台深度融合,借助CuPy等兼容库,原本的Numpy代码能够在GPU上无缝运行,这种兼容性设计保护了开发者在学习方面的投入,还展现了生态的智慧。

在自动微分领域,JAX框架证明了Numpy API仍然具有强大的活力。通过装饰器进行转换,普通的Numpy代码能够获得自动微分的能力,这为科学计算和深度学习的融合开辟了新的道路。

在您最近开展的人工智能项目当中,Numpy帮您解决了哪些事先没有想到的问题?欢迎分享您实际操作时积累的经验,通过点赞交流,使更多开发者能够从中获得益处!